1.zotero版本选择和初始配置

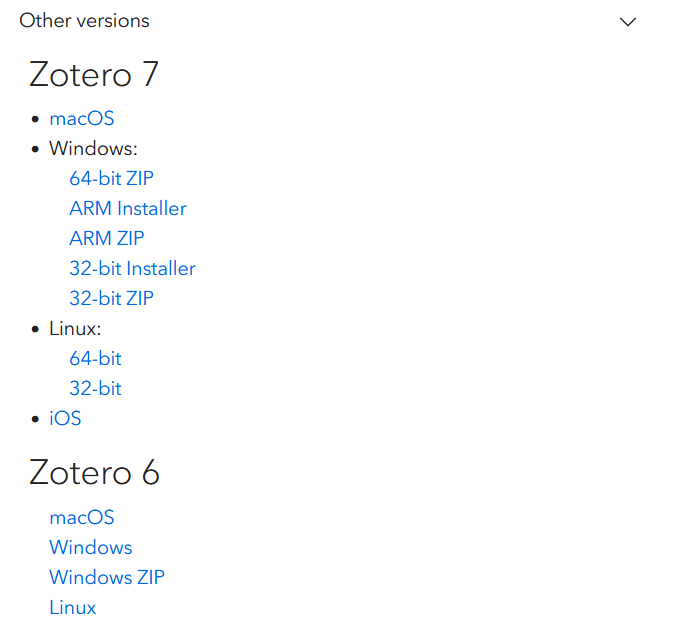

zotero下载官网:https://www.zotero.org/download/

目前提供了Zotero 7和Zotero 6两个版本,个人更喜欢Zotero 6的界面,但是Zotero 7的插件设置相对更加方便,因此下文均采用Zotero 7。

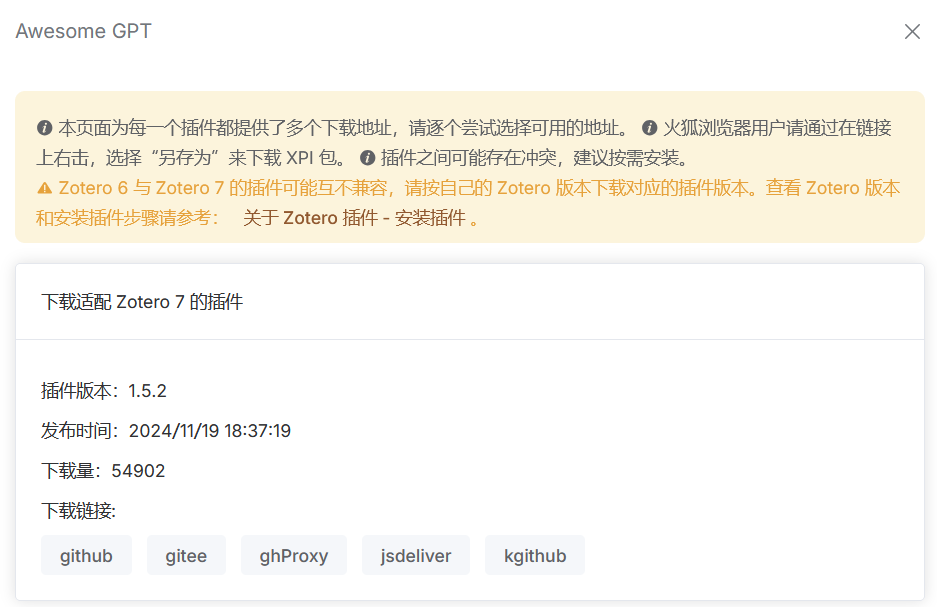

在zotero中需下载Awesome GPT插件,可在Zotero中文社区插件商店:Zotero 中文社区 下载,注意选择Zotero 7版本。

2.ollama下载和本地部署deepseek

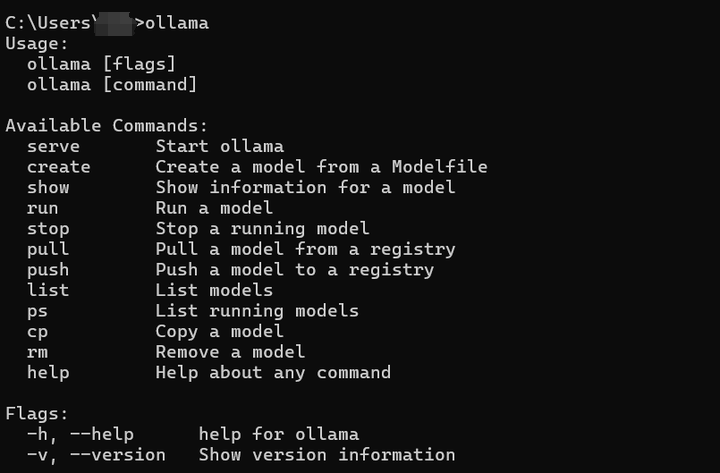

ollama官网:https://ollama.com/ 安装下载即可。

安装完成后打开cmd命令行,输入ollama,显示可用命令等如下图,说明安装成功。

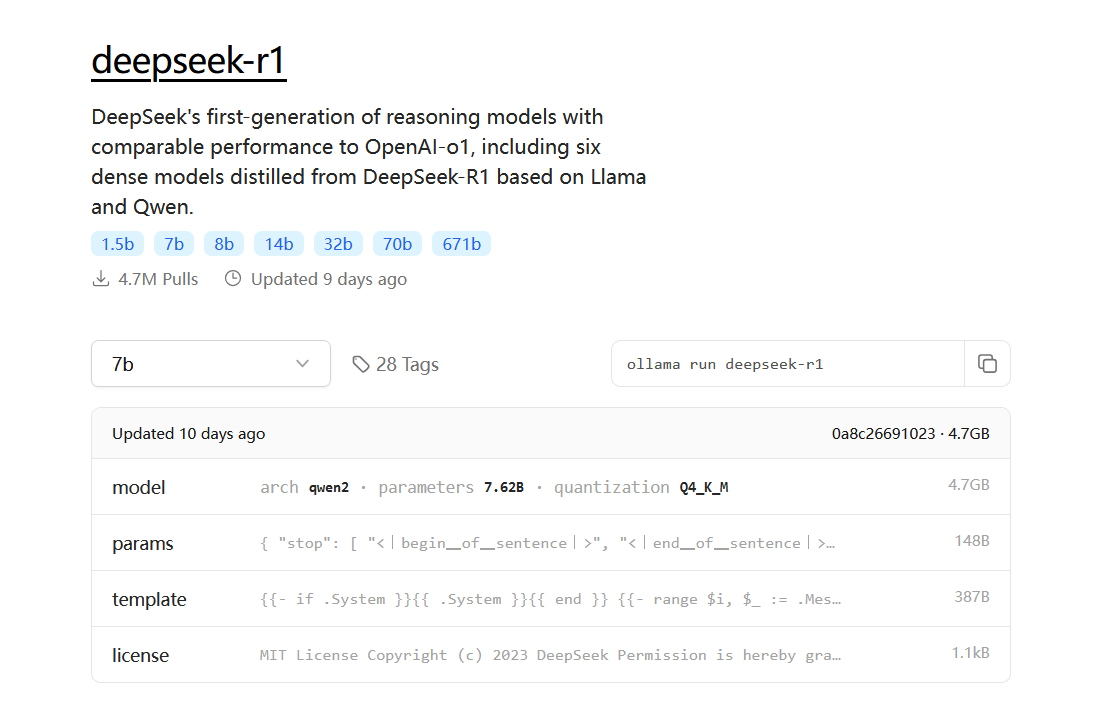

在ollama官网提供了deepseek本地部署模型的不同版本,如下图。

根据电脑显存配置和精度需求选择相应版本。网上的版本选择参考如下。

1.5b 模型,4GB显存就能跑。 7b、8b 模型,8GB显存就能跑。 14b 模型,12GB显存能跑。 32b 模型,24GB显存能跑。

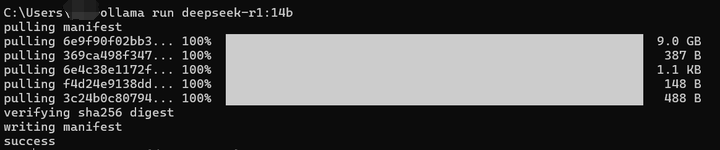

个人下载了8b和14b两个版本,在命令行使用以下语句下载即可。

ollama run deepseek-r1:14b

下载完成后显示 success 即为下载完成。

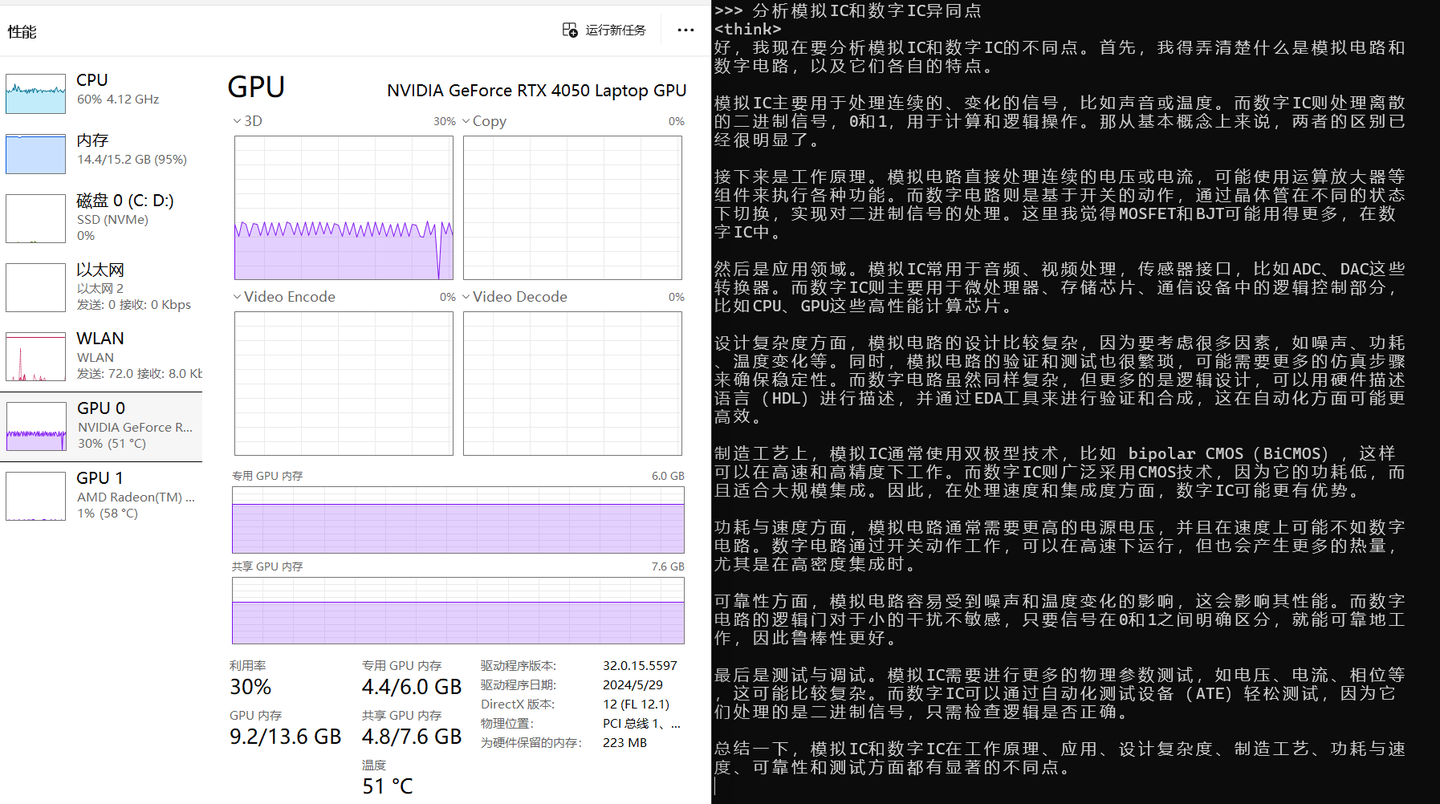

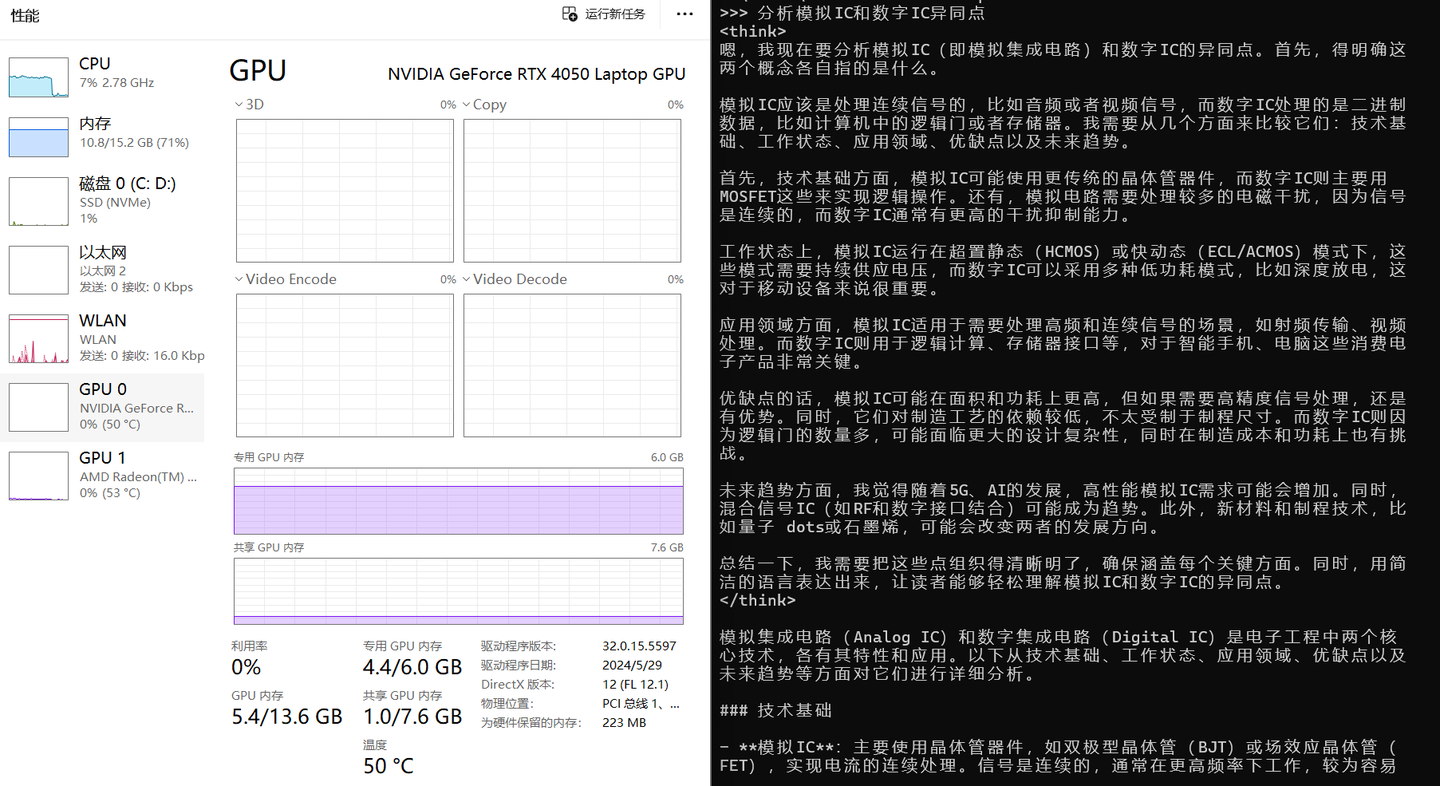

14b和8b的对比如下两图,14b会提高GPU的利用率,且思考的深度会更深入一些,面对一些专业问题会回答更准确一些,但不足之处是输出速度会明显低于8b。

14b

8b

3.deepseek接入到zotero中

终端输入:

ollama serve

获取端口号为11434。(感觉端口号都是这个数字)

因此可调用的API为:http://localhost:11434,使用该API即可调用本地部署模型。

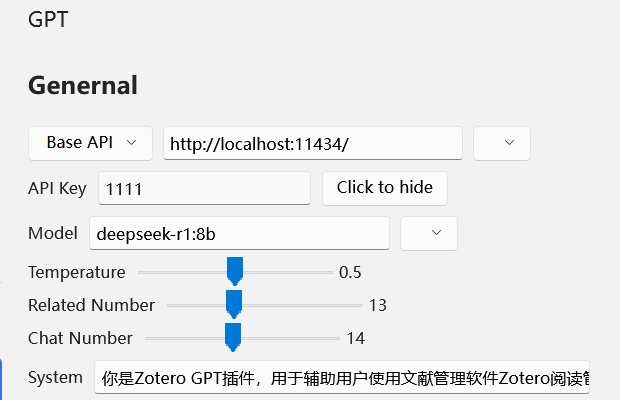

在zotero中点击 编辑->设置->GPT界面可用图形化界面配置GPT参数如下图。

Base API中填入上文得到的API地址;API key填入任意数字,不为空即可;Model填入之前下载的模型名称,其他参数按自身需求设置。

此外网上一些文章提到:

除了要注册deepseek外,由于其不支持文本嵌入模型还需要另找一个供应商提供嵌入模型(也就是插件下面的embedding)

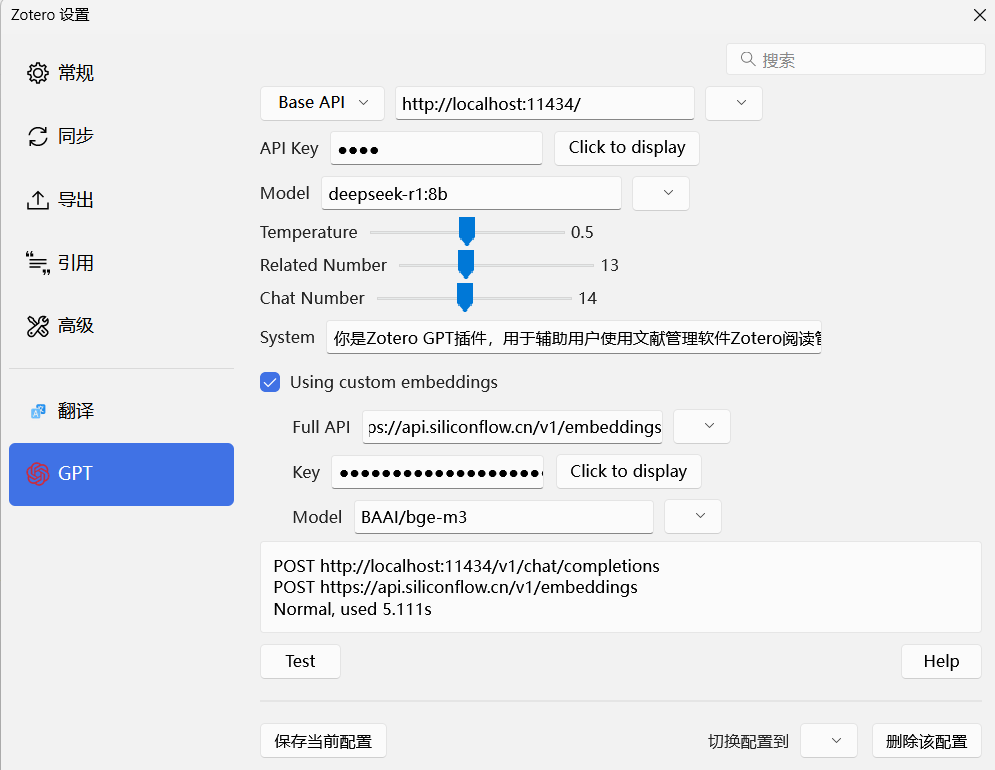

因此最好对GPT设置中的embedding部分也进行配置。

siliconflow模型广场提供了免费的文本嵌入模型:https://cloud.siliconflow.cn/models?types=embedding

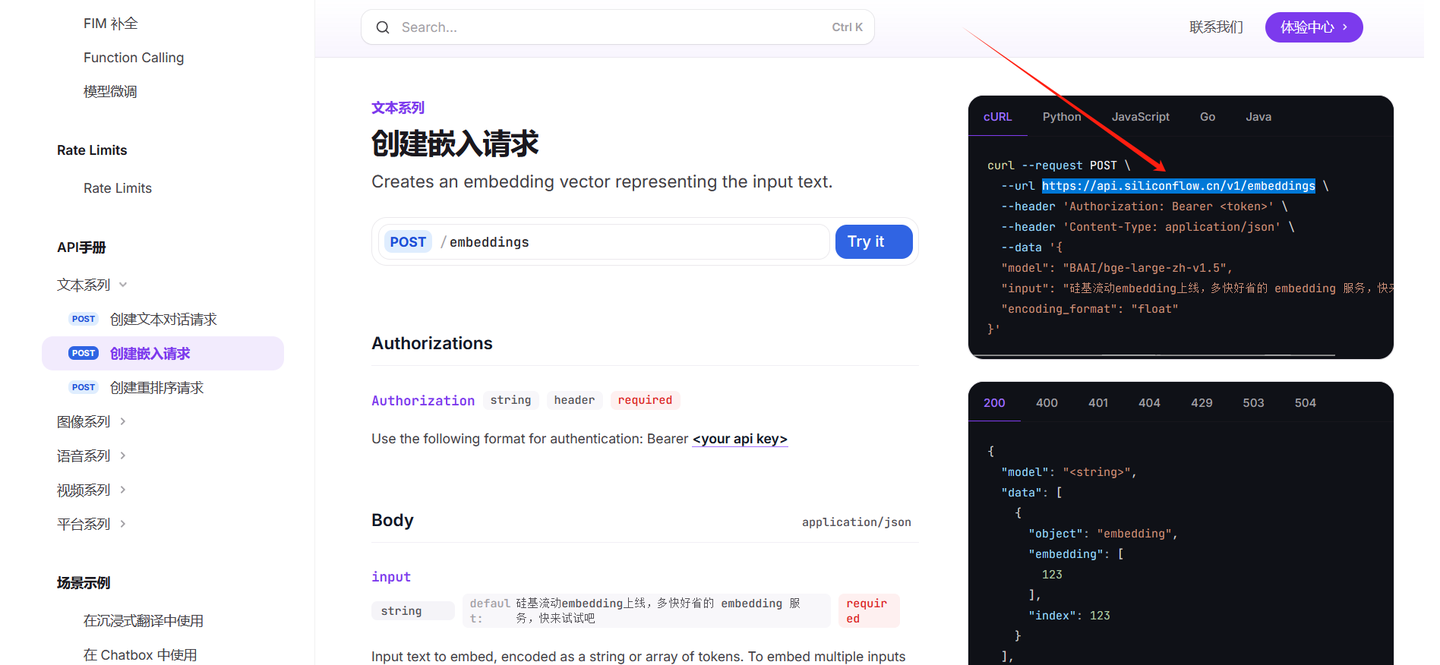

这里可选择BAAI/bge-m3,点击下图中的API文档获取Full API链接。

Full API链接如下图箭头所示。

返回siliconflow主界面,点击API密钥->新建API密钥,创建完成后如下图所示。

将Full API、密钥和模型名分别填入gpt插件配置中,如下图。点击test按键,之后显示normal说明配置正常。(如果不对embeddings进行配置,点击test不会显示normal)

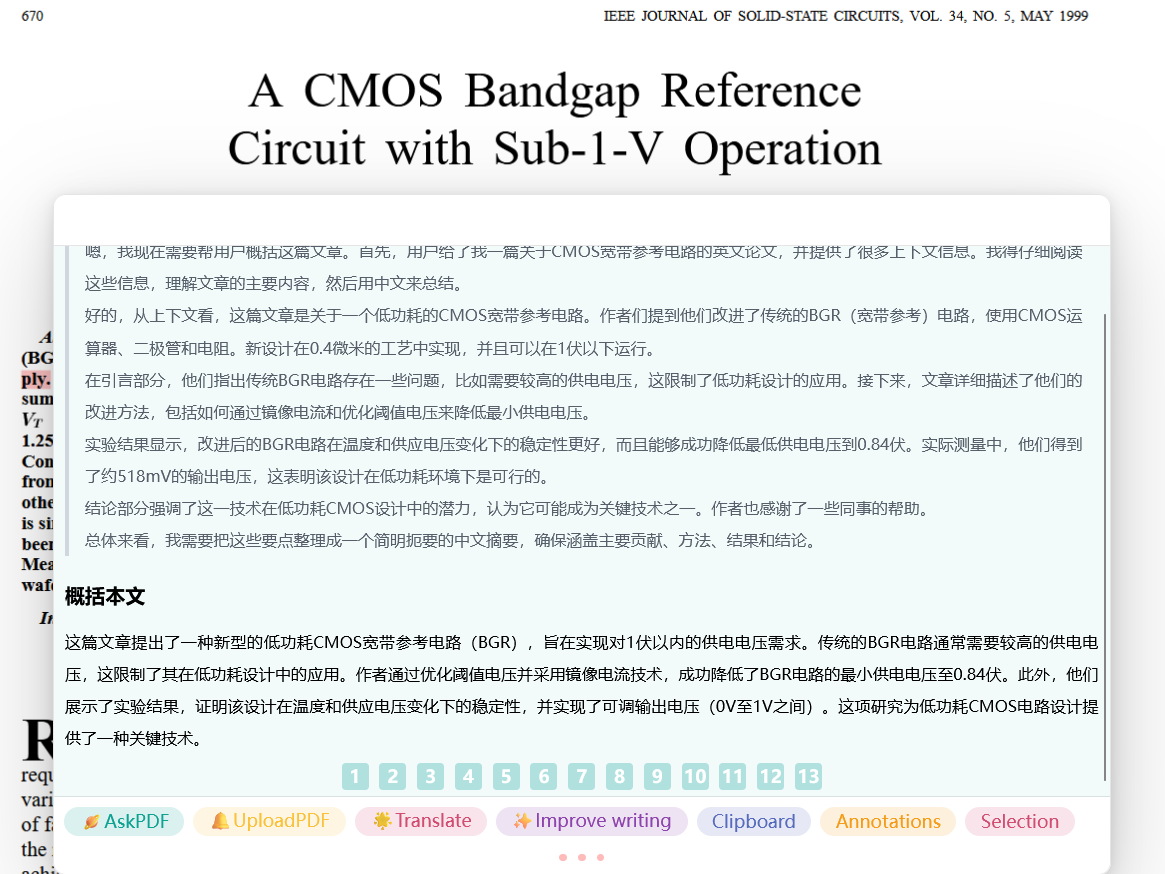

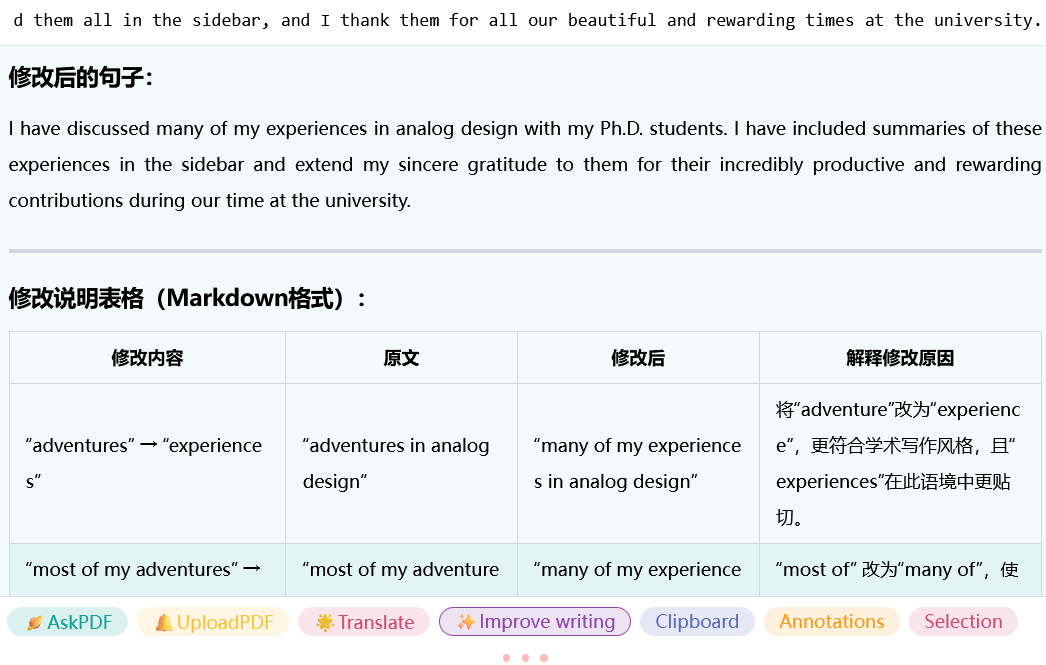

配置完成后,在pdf阅读界面可通过ctrl+/唤起gpt界面,可进行概述文献内容、翻译、语句润色等操作。

(但对一些专业领域的文献实测发现,zotero gpt针对一些电路结构或专业名词可能还是不能理解,如下图中bandgap会翻译成”宽带”。这当然和本地部署的模型较小有关,但本地部署全程免费,且可断网运行,仍可作为一种辅助阅读的工具。)